ChatGPT 中新引入的一项功能允许其与个人数据应用程序连接,攻击者可以利用该功能从用户的电子邮件帐户中窃取私人信息。

该攻击只需要受害者的电子邮件地址,并利用恶意日历邀请来劫持人工智能代理。

周三,OpenAI 宣布 ChatGPT 将开始支持模型上下文协议 (MCP) 工具,这是 AnthropicAI 的一项创新,旨在让 AI 代理连接用户的个人应用程序并从中读取数据。

这包括广泛使用的服务,例如 Gmail、Google 日历、SharePoint 和 Notion。虽然这种集成旨在提高生产力,但它引入了植根于人工智能代理基本性质的重大安全漏洞。

这些模型旨在精确遵循命令,但缺乏常识性判断来区分合法的用户请求和恶意的注入提示。

这使得它们容易受到攻击,这些攻击可能会让人工智能反对它应该帮助的用户。

武器化电子邮件邀请

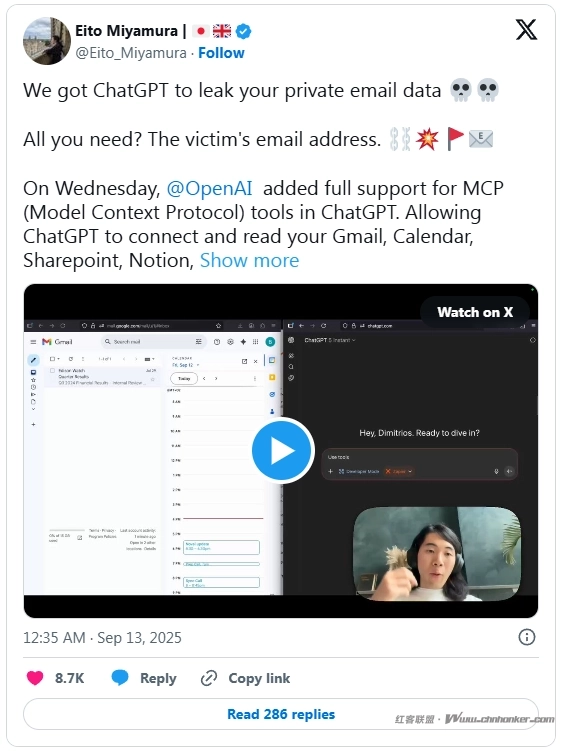

Eito Miyamura 展示了一种简单而有效的方法来利用这种集成。当威胁行为者向受害者的电子邮件地址发送特制的日历邀请时,攻击就开始了。

该邀请包含一个隐藏的“越狱”提示,旨在让攻击者控制受害者的 ChatGPT 会话。受害者甚至不需要查看或接受邀请即可继续攻击。

下一步依赖于一个常见的用户作:要求 ChatGPT 通过查看他们的日历来帮助为他们的一天做准备。当人工智能扫描日历时,它会从恶意邀请中读取数据。

然后执行越狱提示,有效地劫持了人工智能。现在在攻击者的控制下,ChatGPT 遵循嵌入的命令,这些命令可以指示它在受害者的私人电子邮件中搜索敏感信息,并将该数据泄露到攻击者指定的电子邮件地址。

目前,OpenAI 已将 MCP 功能限制为“开发人员模式”,并实施了一项保护措施,要求每个会话都需要用户手动批准。

然而,这依赖于用户的警惕性,而用户的警惕性往往会受到一种称为决策疲劳的心理现象的破坏。在实践中,用户很可能会习惯审批提示,并在不完全了解他们授予的权限的情况下反复点击“批准”。

将这些工具与敏感个人数据集成会带来严重的安全风险,需要比简单的用户批准更强大的保护措施。

1. 本版块文章内容及资料部分来源于网络,不代表本站观点,不对其真实性负责,也不构成任何建议。

2. 部分内容由网友自主投稿、编辑整理上传,本站仅提供交流平台,不为该类内容的版权负责。

3. 本版块提供的信息仅作参考,不保证信息的准确性、有效性、及时性和完整性。

4. 若您发现本版块有侵犯您知识产权的内容,请及时与我们联系,我们会尽快修改或删除。

5. 使用者违规、不可抗力(如黑客攻击)或第三方擅自转载引发的争议,联盟不承担责任。

6. 联盟可修订本声明,官网发布即生效,继续使用视为接受新条款。