人工智能应用的残酷真相

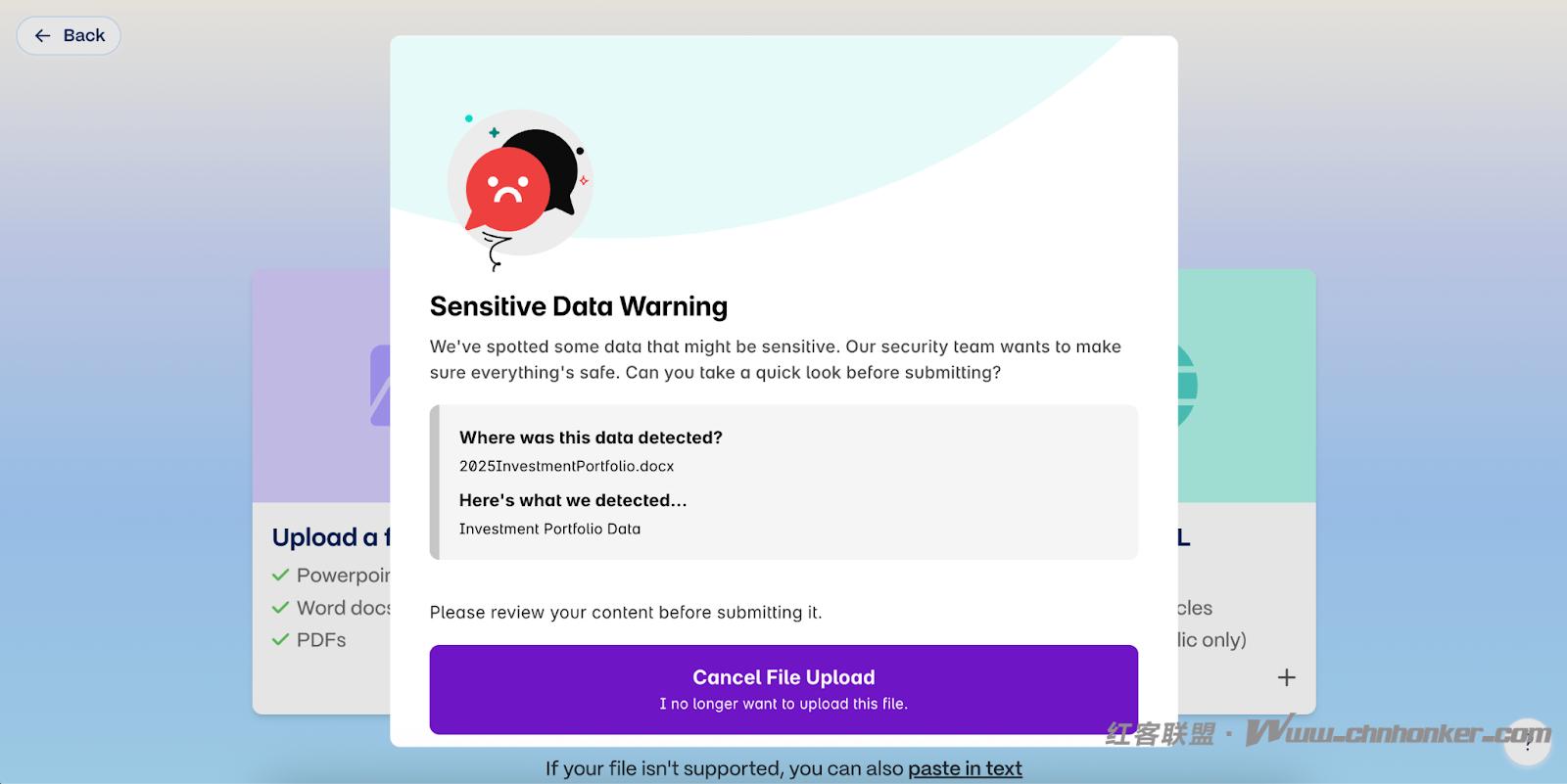

麻省理工学院(MIT)的《商业人工智能现状报告》显示,虽然40%的组织购买了企业法学硕士(LLM)订阅,但超过90%的员工在日常工作中积极使用人工智能工具。同样,Harmonic Security的研究发现,45.4%的敏感人工智能交互来自个人电子邮件账户,员工完全绕过了公司的控制。

可以理解的是,这引发了人们对日益壮大的“影子人工智能经济”的诸多担忧。但这究竟意味着什么?安全和人工智能治理团队又该如何克服这些挑战?

人工智能的使用是由员工而非委员会推动的

企业错误地认为人工智能的应用是自上而下、由其富有远见的商业领袖定义的。我们现在知道这是错误的。在大多数情况下,员工自下而上地推动采用,通常缺乏监督,而治理框架仍然自上而下地定义。即使他们拥有企业认可的工具,他们也常常会避开这些工具,转而选择其他更能提高生产力的新工具。

除非安全领导者了解这一现实,发现并管理这一活动,否则他们将使企业面临重大风险。

为何阻断会失败

许多组织尝试采用“阻止并等待”策略来应对这一挑战。这种方法旨在限制对知名人工智能平台的访问,并希望减缓其采用速度。

但现实却并非如此。

人工智能不再是一个可以轻易屏蔽的领域。从 Canva 和 Grammarly 这样的生产力应用,到嵌入助手的协作工具,人工智能几乎融入了所有 SaaS 应用。屏蔽一种工具只会驱使员工转向另一种工具,通常是通过个人账户或家用设备,而企业却无法真正了解其实际用途。

当然,并非所有企业都如此。具有前瞻性的安全和AI治理团队正在积极了解员工正在使用什么工具以及其用例。他们力求了解正在发生的事情,并帮助员工尽可能安全地使用这些工具。

影子人工智能发现是治理的当务之急

人工智能资产清单是一项监管要求,而非可有可无。欧盟《人工智能法案》等框架明确要求各组织保持对正在使用的人工智能系统的可见性,因为没有发现就没有清单,没有清单就无法治理。影子人工智能是其中的关键组成部分。

不同的人工智能工具带来不同的风险。有些工具可能会悄悄地利用专有数据进行训练,有些则可能将敏感信息存储在中国等司法管辖区,从而造成知识产权风险。为了遵守法规并保护业务,安全领导者必须首先全面了解人工智能的使用范围,包括受批准的企业账户和未经批准的个人账户。

一旦拥有了这种可视性,组织就可以将低风险用例与涉及敏感数据、受监管的工作流程或地理位置暴露的用例区分开来。只有这样,他们才能实施有效的治理政策,既保护数据,又提高员工的工作效率。

Harmonic Security 如何提供帮助

Harmonic Security 通过为员工使用 AI 提供智能控制来实现这一目标。这包括对影子 AI 的持续监控,以及为每个应用程序提供现成的风险评估。

Harmonic 并不依赖静态的阻止列表,而是提供对已批准和未批准的 AI 使用情况的可见性,然后根据数据的敏感性、员工的角色和工具的性质应用智能策略。

这意味着营销团队可能被允许将特定信息放入特定的内容创建工具中,而人力资源或法务团队则被禁止使用个人账户存储敏感的员工信息。这得益于能够在员工共享数据时识别和分类信息的模型。这使得团队能够以必要的精度执行人工智能政策。

前进的道路

影子人工智能 (Shadow AI) 势不可挡。随着越来越多的 SaaS 应用嵌入 AI,非托管式使用只会愈演愈烈。如果组织今天无法解决发现问题,那么未来将无力治理。

未来之路在于智能治理,而非阻拦。影子人工智能发现技术为首席信息安全官 (CISO) 提供了所需的可视性,以保护敏感数据、满足监管要求,并赋能员工安全地利用人工智能的生产力优势。

Harmonic Security 已经在帮助企业迈出 AI 治理的下一步。

对于 CISO 来说,问题不再是员工是否在使用影子人工智能……而是是否能看到它。

1. 本版块文章内容及资料部分来源于网络,不代表本站观点,不对其真实性负责,也不构成任何建议。

2. 部分内容由网友自主投稿、编辑整理上传,本站仅提供交流平台,不为该类内容的版权负责。

3. 本版块提供的信息仅作参考,不保证信息的准确性、有效性、及时性和完整性。

4. 若您发现本版块有侵犯您知识产权的内容,请及时与我们联系,我们会尽快修改或删除。

5. 使用者违规、不可抗力(如黑客攻击)或第三方擅自转载引发的争议,联盟不承担责任。

6. 联盟可修订本声明,官网发布即生效,继续使用视为接受新条款。