人工智能在企业环境中日益重要的作用,加剧了首席信息安全官(CISO)推动有效的人工智能治理的紧迫性。对于任何新兴技术而言,治理都并非易事,而有效的治理则更是难上加难。大多数组织的第一反应是制定严格的政策:撰写一份政策文件,发布一系列限制措施,并期望以此控制风险。然而,有效的治理并非如此。它必须是一个动态的系统,能够影响人工智能的日常使用方式,在不减缓创新步伐的前提下,引导组织安全地实现变革。

对于首席信息安全官(CISOs)而言,在人工智能时代找到安全与速度之间的平衡至关重要。这项技术既是企业自互联网诞生以来面临的最大机遇,也是最大风险。在缺乏防护措施的情况下推进过快,可能导致敏感数据泄露到提示词中、影子人工智能泛滥,或者监管漏洞成为责任隐患。推进过慢,则竞争对手会凭借强大到难以抗衡的变革性效率领先。无论选择哪条路,其后果都可能让首席信息安全官丢掉工作。

反过来,他们不能领导一个“否决部门”,在这个部门中,人工智能采用计划会受到组织安全职能的阻碍。相反,找到一条可行之路至关重要,要将治理与组织的风险承受能力和业务优先级相结合,使安全职能真正成为 revenue 的推动力。在本文中,我将分享三个要素,帮助首席信息安全官实现这一转变,并推动人工智能治理计划,以支持大规模的安全采用。

1. 了解实际情况

2022年11月ChatGPT刚出现时,我认识的大多数首席信息安全官都急忙发布了严格的政策,告知员工不能做什么。考虑到敏感数据泄露是一个合理的担忧,这一举措的初衷是好的。然而,尽管这种“从文档出发”的政策在理论上很完善,但在实践中却很少奏效。由于人工智能的发展速度极快,人工智能治理必须以“从现实出发”的思维来设计,要考虑到组织内部实际发生的情况。这就要求首席信息安全官对人工智能有基础性的了解:包括技术本身、它的嵌入位置、哪些SaaS平台在支持它,以及员工如何使用它来完成工作。

人工智能清单、模型注册表和跨职能委员会听起来可能像是流行术语,但它们是切实可行的机制,能够帮助安全负责人培养这种人工智能素养。例如,人工智能物料清单(AIBOM)可让人清晰了解为人工智能模型提供支持的组件、数据集和外部服务。就像软件物料清单(SBOM)会明确第三方依赖项一样,AIBOM能确保负责人知晓正在使用的数据、数据来源以及所带来的风险。

模型注册表对于已投入使用的人工智能系统起着类似的作用。它们会追踪哪些模型已部署、上次更新时间以及运行表现,以防止“黑箱蔓延”,并为模型的补丁更新、停用或扩大使用范围等决策提供依据。人工智能委员会确保监督工作不会仅由安全部门或信息技术部门承担。这些委员会通常由指定的人工智能负责人或风险官担任主席,成员包括法律、合规、人力资源和业务部门的代表——将治理从孤立的指令转变为一项共同责任,从而平衡安全顾虑与业务成果。

2. 使政策与组织速度保持一致

如果没有切实可行的前瞻性政策,安全负责人往往会陷入制定无法实际执行的控制措施的陷阱。我通过我的一位首席信息安全官同事亲眼目睹了这一点。他知道员工们已经在尝试使用人工智能,于是努力推动员工负责任地采用几款生成式人工智能应用。然而,当一位新的首席信息官加入该组织,并认为正在使用的生成式人工智能应用过多时,这位首席信息安全官接到指示:在选定一个企业级平台之前,禁止所有生成式人工智能。一年后,那个单一平台仍未实施,员工们正在使用未经批准的生成式人工智能工具,这使该组织面临影子人工智能带来的漏洞风险。这位首席信息安全官陷入了困境,他试图执行一项无法落实的全面禁令,不断遭到批评,却没有权力实施一个可行的解决方案。

当政策的制定速度快于其执行速度,或者政策未能预见组织的采用节奏时,就会出现这种情况。如果政策不能随着领导层变动、嵌入式人工智能功能的发展以及员工将新工具融入工作的自然方式而演变,那么那些在书面上看似果断的政策很快就会过时。治理必须具备足够的灵活性以适应变化,否则就可能导致安全团队去执行那些不可能完成的任务。

前进的方向是将政策设计为动态文件。它们应随着业务的发展而演变,以实际用例为依据,并与可衡量的成果保持一致。治理也不能仅停留在政策层面,还需要延伸到指导日常工作的标准、程序和基准中。只有这样,员工才能真正了解在实践中安全采用人工智能的具体样子。

3. 使人工智能治理具有可持续性

即使有强有力的政策和路线图,员工仍会以未经正式批准的方式使用人工智能。安全负责人的目标不应是禁止人工智能,而是让负责任地使用人工智能成为最便捷、最具吸引力的选择。这意味着要为员工配备企业级的人工智能工具,无论是购买的还是自主开发的,这样他们就无需选择不安全的替代方案。此外,这还意味着要强调并强化积极行为,让员工认识到遵守规则而非绕过规则的价值。

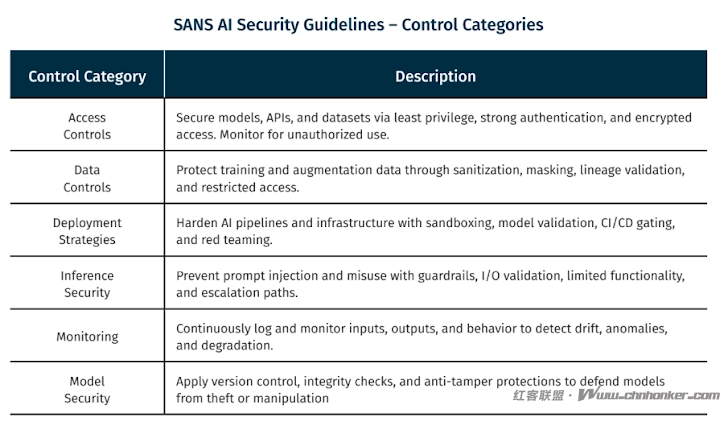

可持续治理还源于利用人工智能和保护人工智能,这是SANS研究所最近发布的《安全人工智能蓝图》的两大支柱。为了有效治理人工智能,首席信息安全官应授权其安全运营中心团队有效利用人工智能进行网络防御——实现降噪和信息扩充的自动化,根据威胁情报验证检测结果,并确保分析师始终参与升级和事件响应流程。他们还应确保制定适当的控制措施,以保护人工智能系统免受对抗性威胁,正如SANS关键人工智能安全指南中所述。

在2025年SANS网络防御计划中了解更多信息

今年12月,SANS将在华盛顿特区举办的“2025年SANS网络防御计划”中提供《LDR514:安全战略规划、政策与领导力》课程。该课程专为那些希望超越通用治理建议、学习如何构建以业务为导向的安全计划(从而引导组织安全采用人工智能)的领导者设计。课程将涵盖如何制定可执行的政策、使治理与业务战略保持一致,以及将安全融入企业文化,以便您能够带领企业安全地度过人工智能时代。

如果你已准备好将人工智能治理转化为业务推动力,请在此处注册参加2025年SANS CDI大会。

注:本文由SANS研究院研究员弗兰克·金供稿。

1. 本版块文章内容及资料部分来源于网络,不代表本站观点,不对其真实性负责,也不构成任何建议。

2. 部分内容由网友自主投稿、编辑整理上传,本站仅提供交流平台,不为该类内容的版权负责。

3. 本版块提供的信息仅作参考,不保证信息的准确性、有效性、及时性和完整性。

4. 若您发现本版块有侵犯您知识产权的内容,请及时与我们联系,我们会尽快修改或删除。

5. 使用者违规、不可抗力(如黑客攻击)或第三方擅自转载引发的争议,联盟不承担责任。

6. 联盟可修订本声明,官网发布即生效,继续使用视为接受新条款。